Deployment - Ausblick und Reflektion

Deployment - Ausblick und Reflektion#

Grundsätzlich wurde gezeigt, dass Satellitenbilder mittels Object Detection ausgewertet werden können.

Obwohl in der Modellierung gut zwischen Flugzeugen und Helikoptern unterschieden werden konnte, haben sich beim Deployment ein paar Fehlklassifikation ergeben. Das Proof of Concept Modell hat teilweise keine Detectionen ausgegeben, wo SAHI Teilbestände detektiert hat.

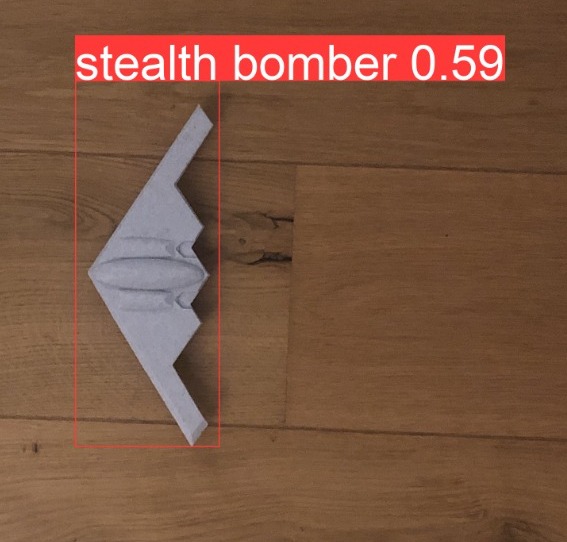

Bezugnehmend auf die Confusion Matrix von Modell 13, sollte noch mehr in Richtung True Positive trainiert werde. Dies bedarf wesentlich mehr Daten (Bilder und Instanzen), welche zum Beispiel durch 3D-Modellierung erzeugt werden können. Im Abschnitt zum Tarnkappenbomber wurde eine vereinfachte Umsetzung aufgezeigt.

Im Hinblick auf das Eingangs erwähnte Airbus-Produkt, erscheint ein intensiveres und spezifischeres Training als zielführend.

Eine zusätzliche Zeitdimension könnte zur Darstellung von Veränderungen verwendet werden. Eine Anwendung als Frühwarnindikator ist insofern vorstellbar, dass Gebiete ohne Überdachungen überwacht werden können. Dies zeigt sich ins besondere bei den in der Introduction dargestellten Szenarien, wie etwa die Häufung von Kampfhubschraubern an der Grenze zur Ukraine. Zu bemängeln ist also, dass weitere Fluggeräte in Hallen oder unter Abdeckungen stehen könnten und damit für das Modell unsichtbar sind. Solche Auswertungen lassen sich auch durch Aufstellen von Attrappen beeinflussen [dpa, 2022].

In der Praxis könnte Bildmaterial, welches durch Drohnen aufgenommen wurde, zusätzliche domänenspezifische Merkmale auswertbar machen. Eventuell lassen sich Attrappen mit Hilfe von Wärmebildkameras herausfiltern. Interessant ist der Umgang mit Signatur verschleiernder Technologie, wie beispielsweise das Saab Baracuda CoolCam, welches bereits an Großgerät wie Kampfpanzern und Schiffen angebracht wird [saab.com, 2022].

Fig. 45 3D-gedrucktes Modell mit Erkennung#